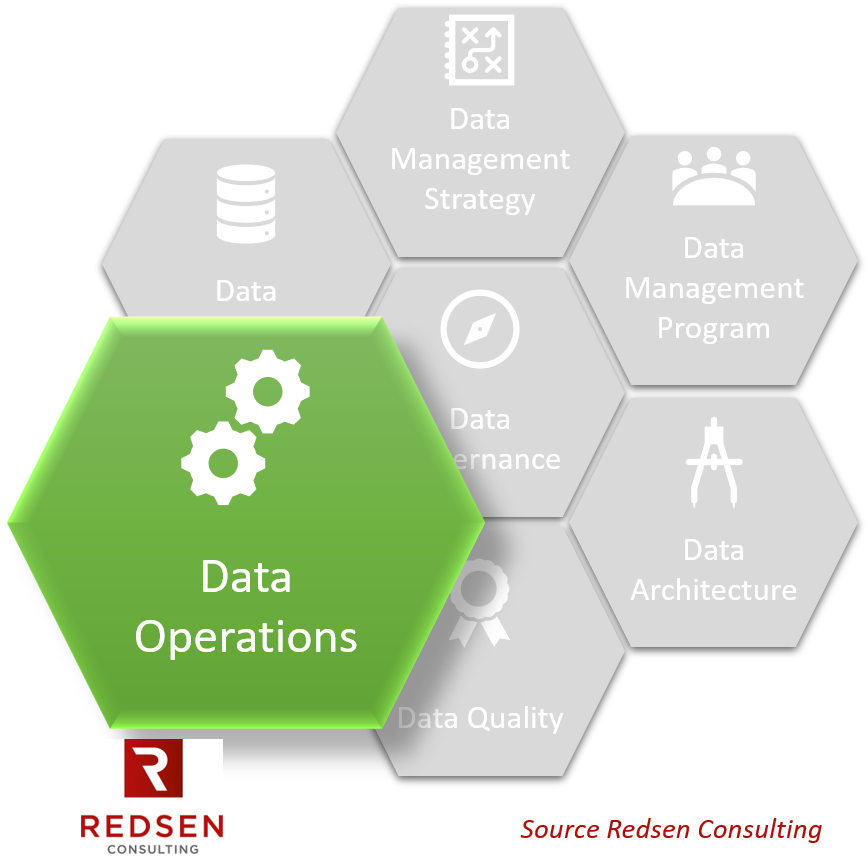

Au sein du Data Management, le domaine « Data Operations » est l’ensemble des disciplines et bonnes pratiques qui vont couvrir la chaîne d’approvisionnement et d’utilisation des données, en lien avec les besoins des processus métier.

Sixième et dernière étape de notre parcours des bonnes pratiques de data management, le domaine « Data Operations » est la branche opérationnelle de la gestion des données.

Data Operations – Une définition

Le Le domaine « Data Operations » regroupe l’ensemble des disciplines et bonnes pratiques qui visent à gérer et exploiter les données tout au long de leur cycle de vie.

Le domaine « Data Operations » regroupe l’ensemble des disciplines et bonnes pratiques qui visent à gérer et exploiter les données tout au long de leur cycle de vie.

Il se compose de 5 disciplines:

- Data Requirements Definition pour assurer l’alignement des données aux objectifs des processus métiers

- Data Provider Management pour assurer le bon approvisionnement des données

- Data Lifecycle Management pour gérer les données tout au long de leur cycle de vie

- Data History, Archiving and Retention pour répondre aux exigences internes, légales et réglementaire en matière de conservation et de traçage

- Data Analytics pour rendre les données valorisables pour les processus métiers

Data Operations – Les disciplines

Data Requirements Definition

La définition des exigences sur les données va avoir une influence sur plusieurs autres disciplines de l’organisation (en particulier Data Profiling, Data Quality Assessment, Data Cleansing, Data Integration, et Data Provider Management). Elle constitue un point d’entrée pour comprendre les attentes des processus métier en matière de données.

C’est en particulier ici que seront capturées les exigences de sécurité et de mise en conformité.

Les bénéfices de la mise en œuvre des bonnes pratiques de définition des exigences de données peuvent se résumer ainsi :

- Prévenir la sous-qualité et la sur-qualité en comprenant les attentes des processus métier en matière de données consommées (« fit-to-purpose »)

- Favoriser un meilleur alignement de la stratégie de gestion des données avec les besoins des processus métier

- Mettre en conformité l’organisation avec ses obligations légales et réglementaires

Les principaux livrables de cette discipline sont :

- Le référentiel d’exigences sur les données (avec traçabilité vers les besoins métier)

- La traçabilité des exigences

- Les spécifications sur les données

- Les décisions d’arbitrage des priorités et des conflits entre les exigences

Data Provider Management

Nous allons donc retrouver ici des bonnes pratiques assez classiques en matière de sous-traitance, appliquées au domaine des données.

Les principaux bénéfices de de l’application de bonnes pratiques dans ce domaine sont :

- La rationalisation et meilleur contrôle des sources données

- Une meilleure adéquation des sources de données avec les besoins des processus métier

Les principaux livrables de cette discipline sont :

- Règles et principes de sous-traitance

- Exigences en matière de fourniture des données

- Contrat-type de fourniture de données

- Critères standards de sélection des sources de données

- Rapport d’évaluation des fournisseurs de données

- Contrats avec les fournisseurs de données

- Accords de Niveau de Service (SLA)

- Rapport d’audit des fournisseurs de données

Data Lifecycle Management

Les bonnes pratiques pour la gestion du cycle de vie de la donnée visent à assurer que les données sont gérées en adéquation avec les besoins métier tout au long de leur cycle de vie (depuis leur création/acquisition jusqu’à leur décommissionnement/archivage).

En effet, il n’est pas rare de voir les organisations accumuler les données au fil du temps sans jamais questionner leur utilité et encore moins leur décommissionnement et archivage quand les données deviennent obsolètes. Il en résulte une masse de données qui amoindrit les autres capacités de data management telles que le profiling, l’évaluation de qualité… et augmentent les risques d’erreurs pour les processus métier.

La gestion du cycle de vie des données s’inscrit dans une démarche proactive qui contribue à diminuer la dette technique sur les données.

Les bénéfices de la discipline « Data Lifecycle Management » seront :

- Optimisation à long-terme du capital de données

- Optimisation des ressources utilisées pour les données

- Garantir l’adéquation des données aux besoins tout au long des processus métier

Les principaux livrables de cette discipline sont :

- Matrice de consommation/production des données

- Diagramme de flux des données

- Cycle de vie type des données avec mapping sur les processus métier

- Cartographie des données

- Référentiel des sources de données autorisées

- Processus et plan de décommissionnement/archivage des données

Data History, Archiving and Retention

Il s’agit donc de définir un ensemble de principes, processus, règles et critères – en lien avec les exigences des métiers – pour gérer les données dans le temps : quelles sont les règles en matière de versionning des données ? Sous quelles conditions les données doivent être archivées ? Quelle est la période (nécessaire ou autorisée) de conservation des données ?… Autant de questions qui doivent trouver leur réponse par la mise en œuvre de ces bonnes pratiques.

Grâce à l’application de bonnes pratiques propres à ce domaine, l’organisation peut espérer atteindre les objectifs suivants :

- Se mettre en conformité avec les exigences légales/réglementaires

- Une meilleure adéquation des données avec les besoins des processus métier

- Une meilleure maîtrise des actifs de données

Les principaux livrables de cette discipline sont :

- Archives et backup des données (encryptées si besoin)

- Procédures d’archivage, de destruction, de restauration

- Historique de changement et d’accès aux données

- Principes et règles métier de rétention

- Tests de restauration des données

- Test d’accès aux données archivées

- Rapports d’audit sur les accès aux données

- Rapport de conformité aux exigences légales/réglementaires

Data Analytics

Le déploiement de bonnes pratiques de « Data Analytics » va favoriser et sécuriser les projets centrés sur le traitement et la valorisation des données, comme le machine learning, des tableaux de bord, des rapports d’analyse de données.

Généralement, l’analyse de données s’articule autour de 3 grandes pratiques :

- Data Collection qui consiste à collecter les données nécessaires à l’analyse

- Data Mining qui consiste à analyser les données pour en tirer de la valeur. C’est ici que le « Data Scientist » intervient pour creuser, investiguer, mettre en valeur les données par des scripts et des techniques statistiques

- Data Visualization est l’art de mettre les résultats du Data Mining en graphique pour permettre leur analyse

La mise en œuvre des pratiques de Data Analysis a clairement évolué ces dernières années vers plus d’agillité, agilité consistant à itérer entre data collection, data mining et data visualization. La clé étant d’obtenir, par la visualisation, un feedback rapide des partie prenantes et ajuster en les traitements en conséquence. Une telle agilité requiert en amont une architecture elle-aussi qualifiée d’agile où les données sont accessibles rapidement : c’est ici qu’interviennent, entres autres, les infrastructures de Data Lake ou de Data Virtualization et les principes de DataOps.

Assez naturellement, les livrables de l’analyse de données sont :

- Des tableaux de bord

- Des rapports d’analyse de données

- Des techniques statistiques

Maturité

- Au niveau 1, les exigences sur les données et leur approvisionnement sont identifiées. Des tests sont réalisés pour vérifier la qualité des données approvisionnées. Des données historiques sont disponibles et les dépôts de données sont sauvegardés et archivés. En matière de Data Analytics, l’organisation repose essentiellement sur des fichiers Excel.

- Au niveau 2, les exigences sur les données sont dérivées des besoins métier et gérées selon un processus défini. Des critères de qualité sont définis pour l’approvisionnement des données. Le mapping données-processus métier est documenté pour comprendre le cycle de vie des données. Des principes d’historisation, de conservation, de conservation et de conservation des données sont définis. Des tests de restauration et d’accès aux données sont conduits. En matière de Data Analytics, le reporting est principalement opérationnel et se limite à observer les faits passés.

- Au niveau 3, les exigences sur les données sont priorisées selon les priorités des métiers. Les sources d’approvisionnement des données sont évaluées selon des critères. Des accords de niveau de service (ANS) sont définis. Des principes pour gérer le changement sur les données sont définis et mis en œuvre. En matière de Data Analytics, des standards de reporting sont disponibles.

- Au niveau 4, des indicateurs sont utilisés pour piloter la gestion des exigences, la gestion des changements sur les données et la gestion du cycle de vie des données. Des métriques sont utilisées pour vérifier la conformité légale/réglementaire. Les ANS sont pilotés grâce à des indicateurs. En matière de Data Analytics, les données sont utilisées au travers de l’organisation comme outils de prédiction et d’amélioration.

- Au niveau 5, des pratiques sont mises en œuvre pour améliorer en continu la gestion de exigences, l’approvisionnement des données et la gestion du cycle de vie des données. En matière de Data Analytics, les données sont exploitées pour mesurer et prédire la performance des processus.

Pour aller plus loin

Redsen Consulting aide les organisations à évaluer leur niveau de maturité dans le domaine du Data Management ! Remplissez le formulaire en ligne Audit Quick Start Data Management et bénéficiez d’un diagnostic gratuit réalisé par nos experts.