Le passage au cloud est devenu une telle évidence qu’on peut désormais évoquer la phase suivante : et après, comment fait-on ?

En effet, on est en train de s’apercevoir que le cloud ne se gère pas tout seul, surtout quand on a adopté une configuration multicloud.

Le principal problème qui remonte à la surface, c’est que les coûts peuvent vite grimper au plafond si on ne surveille pas ses choix techniques et les options de sa ou ses configurations en ligne. Mais, attendez une minute, on ne nous avait pas promis que le cloud allait coûter moins cher que les data-centers propriétaires ?

Oui, on l’avait promis…

Ah si, c’est bien vrai, c’était promis. Mais, comme à chaque fois qu’on fait cette promesse en informatique, elle se révèle difficile à tenir. Comme toujours, il faut lire les conditions écrites en petits caractères !

Car, si le data-center de votre fournisseur dans le cloud est bien plus efficace sur tous les plans que celui que vous vous efforciez de maintenir contre vents et marées, il n’est pas gratuit et tous les usages (vraiment tous les usages…) vous seront facturés. Dura lex, sed lex. Là, terminés les gaspillages invisibles, finis les usages sans contrôle ou alors, la facture va être lourde et décevante… Vous voulez un exemple ?

Une organisation s’est aperçue qu’une simple erreur de configuration logicielle (une erreur bénigne) envoyait une (grosse) sauvegarde sur le cloud plutôt que sur son NAS local. Au bout d’un mois, la facture s’élevait déjà à $40 000… pas rien, n’est-ce pas !

Certaines études estiment que jusqu’à 8,8 milliards de Dollars ont été gaspillés en 2020 suite à une utilisation défaillante des ressources cloud.

Gérer son cloud, facile à dire !

En gros, on ne peut plus laisser la lumière allumée dans des pièces qu’on n’occupe pas ou des robinets couler dans des baignoires qu’on n’utilisera pas. Il faut GERER son utilisation cloud (comme le rappel le douloureux et récent incendie du datacenter OVH, voir en conclusion de cette chronique…) et le mieux est de le faire au quotidien afin de ne pas laisser des négligences se transformer en trous béants dans le budget. Un exemple : la planification rigoureuse des heures d’utilisation permet d’éviter que des VM tournent inutilement la nuit et le week-end.

Mais la recommandation “gérez votre cloud” ne suffit pas car il s’avère que c’est plus difficile à faire qu’à dire. En effet, les grands fournisseurs vont vous abreuver de données et de tableaux de bord ad hoc. Et, très vite, on se retrouve noyé dans ces données !

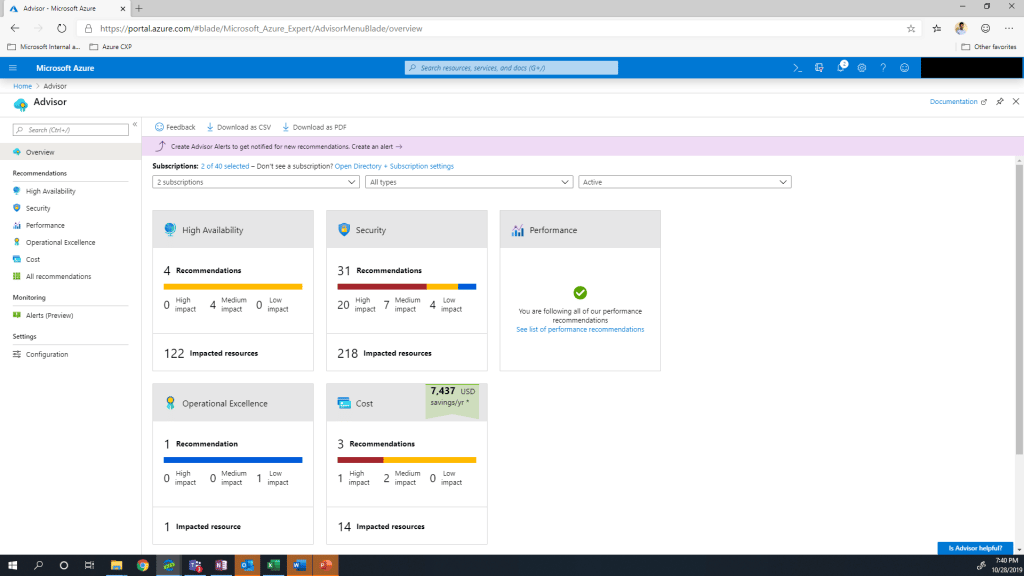

Quand vous avez réussi à faire le tour de “AWS Trusted Advisor” et “AWS Cost Explorer”, vous devez refaire de même avec “Azure Advisor !” (pour ne citer que ces deux fournisseurs)… De plus, comment être sûrs que le “AWS Trusted Advisor” ou celui d’Azure vont vraiment vous offrir des recommandations allant dans VOTRE sens ?

En effet, on peut facilement penser que votre fournisseur de cloud ne s’inquiète pas vraiment de vous voir trop dépenser…

Le multicloud inévitable ?

Mais, justement, la grande majorité des organisations qui ont déjà basculé vers le cloud sont forcément concernées par l’approche multicloud et ce n’est pas toujours par choix. Quand on fait le recensement de l’utilisation des différents services en ligne au sein de son organisation, on s’aperçoit vite qu’on est déjà en multi-cloud même sans l’avoir désiré !

Pour éviter le “SaaS Waste”

En 2020, les entreprises possédaient en moyenne près de 137 logiciels SaaS différents, soit une augmentation de 30 % par rapport à 2018. Souvent, la plupart de ces solutions ne sont pas exploitées en interne et les dépenses en matière de logiciels SaaS augmentent tous les ans ; +50 % ces deux dernières années d’après le cabinet de conseil Saas Advisor. Le “SaaS Waste” (waste = gaspillage) représente un risque financier et sécuritaire évident pour les entreprises. Heureusement, il existe des solutions capables d’identifier automatiquement l’ensemble de ces SaaS.

Aujourd’hui, plus de 50% des solutions SaaS payées par les entreprises ne seraient pas référencées par les équipes IT, toujours selon Saas Advisor.

Et ce n’est pas la seule (mauvaise) surprise que produit cet indispensable recensement : doublons, services peu ou pas utilisés, gestion éparpillée et ainsi de suite. Évidemment, aucun des grands fournisseurs de services Cloud ne propose de solution unifiée afin de faire face à cette diversité…

La CMP, l’incontournable solution

Bref, pour toutes ces raisons, le recours à une CMP s’impose. Une CMP est une “Cloud Management Platform” qui, comme son nom l’indique, est une plateforme permettant de gérer facilement une ou plusieurs infrastructures Cloud depuis une interface qu’on espère intuitive et qui sera au moins unifiée. Une CMP se présente comme une suite d’outils logiciels intégrés permettant à une entreprise de surveiller et gérer des infrastructures de Cloud public, privé, hybride ou multi-cloud.

Il existe différents types de CMP et les fonctionnalités proposées varient forcément d’une solution à l’autre. Les CMP les plus basiques ne permettent de gérer qu’une facette de l’infrastructure Cloud, les meilleures solutions récentes fournissent à la fois des solutions pour la gestion des coûts, pour la sécurité, et pour l’automatisation du Cloud. Celles qui sont multicloud permettent de gérer plusieurs infrastructures Cloud de fournisseurs différents depuis une interface unifiée (et c’est bien ce qu’on veut !).

Enfin, les plateformes de gestion de Cloud hybride permettent de gérer depuis la même interface un environnement Cloud et un environnement sur site. Bref, on l’aura compris, comme les CMP sont nombreuses, on est face à un spectre de fonctionnalités variées.

Dans l’ensemble, on peut s’attendre au tableau général suivant avec une CMP typique : elle propose une interface unifiée (même si plusieurs fournisseurs de cloud sont pris en compte) et des fonctionnalités de reporting et d’analyse pour obtenir des conseils sur la consommation sur le cloud de l’entreprise. Elle permet aussi de surveiller et de gérer les services cloud pour permettre de planifier les besoins et le déploiement des ressources.

Les CMP sont également censées permettre de gérer les ressources Cloud : machines virtuelles, stockage, réseaux… et dans l’idéal permettre la migration de ressources entre différents environnements.

Concernant la gestion des finances, les CMP doivent permettre de suivre et de répartir les dépenses de l’entreprise dans le Cloud Computing, de générer des rapports et de prédire les futures charges. Enfin, ces plateformes doivent permettre à l’administrateur de fixer des règles pour contrôler l’utilisation des ressources Cloud et offrir des fonctionnalités de sécurité comme le chiffrement et la gestion des accès.

Une offre abondante (trop ?)

Du côté des fournisseurs, on retrouve tous ceux qui sont concernés de près (IBM) ou de loin (Cisco, HPE) par la vague du cloud mais aussi des nouveaux spécialistes comme Flexera, Embotics ou Servicenow. L’offre est abondante, presque trop et un service permettant de comparer facilement les différentes solutions serait le bienvenu !

Ceci dit, l’avenir s’annonce radieux pour les solutions de type CMP car il y a beaucoup, beaucoup à faire dans l’univers du cloud qui n’arrête pas de s’étendre. Un exemple de cette extension continue : face à la masse et à la diversité des solutions SaaS, il faut un moyen de les relier et de les intégrer. Celui-ci existe désormais et c’est l’IPaaS (Integration Platform as a service).

Et pour demain ?

Tout cela est intéressant mais pas très surprenant. En effet, à partir du moment où le cloud était largement adopté, il allait forcément s’étendre, se complexifier et donc demander des solutions de gestion un peu évoluées, ce que nous apportent les CMP et l’IPaaS.

Mais pour l’avenir, à quoi peut-on s’attendre ?

C’est là que ça devient vraiment intéressant car il y a une fenêtre d’opportunités pour que les éditeurs de logiciels indépendants reprennent la main face aux géants du cloud que sont Amazon, Microsoft, Google et Alibaba. En effet, poussons la logique des CMP jusqu’au bout et que voit-on ?

Une toute autre classe de fournisseurs pourrait apparaître et prospérer : les courtiers en cloud. Dans ce cadre, les services de CMP ne se contenteraient plus de faire de la surveillance (monitoring) et des recommandations mais pourraient en plus déplacer les processus et applications sur les clouds aux tarifs les plus avantageux en fonction du moment. En effet, on peut imaginer que les fournisseurs de cloud fassent évoluer leurs prix en fonction de la charge et d’autres facteurs importants pour eux. On se retrouverait donc avec des services dont les prix fluctuent en permanence. Après la volatilité des cours du pétrole, nous aurions la même chose pour les ressources informatiques !

Les courtiers, nouveaux maîtres du jeu !

Dans ce contexte, les éditeurs de CMP bénéficieraient d’un atout énorme : ils seraient les mieux placés pour faire profiter leurs clients des meilleurs tarifs tout au long de la semaine. Pour cela, il faudrait que les processus et les applications (ainsi que leurs données !) soient déplaçables en permanence. Imaginons que j’ai une base de données sur AWS mais, en début de semaine, voilà qu’Azure casse les prix : mon CMP me permet de passer de l’un à l’autre automatiquement et sans perte. Mieux, il le fait même à ma place, automatiquement en fonction de paramètres que j’ai fixés et que je peux faire évoluer en fonction de ses recommandations.

Bien entendu, cet épisode “d’informatique fiction” va demander certaines évolutions avant de pouvoir devenir réalité : les infrastructures des géants du cloud devront être suivies en permanence pour être cotées en fonction de l’évolution de leurs disponibilités et de leurs tarifs. Aujourd’hui, cela paraît encore lointain comme perspective mais c’est loin d’être impossible.

Revenons à notre présent où les perspectives sont loin d’être aussi fermées qu’on voudrait nous le faire croire (c’est cloud pour tout le monde, point).

Face à cette unanimité, des voix discordantes se font entendre…

Alors que l’usage du cloud pour les organisations est en train de s’établir comme seule vérité (c’est-à-dire la seule solution à envisager) avec la force de l’évidence, quelques voix discordantes commencent à se faire entendre ça et là. Par exemple, nous avons Jean-Paul Smets qui déclare (source https://www.journaldunet.com/web-tech/cloud/1497525-que-pouvons-nous-attendre-du-cloud-computing-a-l-avenir/) :

Mais pourquoi externaliser le cloud, alors que nous pouvons héberger l’infrastructure nous-mêmes dans un petit bureau ? La plupart des moyens sont déjà disponibles en open source. Lorsque les personnes apprendront à les intégrer et à les exploiter par eux-mêmes, cela entraînera une révolution dans notre attitude vis-à-vis des grandes entreprises technologiques.

…

Les stratégies de verrouillage des fournisseurs actuels de services dans le cloud sont désormais mieux comprises. Les responsables informatiques se rendent compte qu’ils paient environ dix fois le prix d’un service qui pourrait tenir dans un petit coin de leur bâtiment et fonctionner entièrement avec des logiciels libres. Ils sont également conscients du fait que leurs secrets commerciaux ne sont pas bien protégés et qu’en utilisant certains services dans le cloud, ils pourraient même risquer la prison comme cela s’est produit pour des dizaines d’entreprises dont les informations sensibles ont été divulguées au gouvernement par leur fournisseur de services cloud.

En gros, Jean-Paul Smets nous dit qu’on peut faire du cloud chez soi, il suffit pour cela d’utiliser les mêmes logiciels et, justement ça tombe bien, la plupart sont Open Source !

La plupart des composants clés d’une infrastructure cloud sont déjà disponibles en open source (logiciels et matériels). La bibliothèque d’IA la plus importante, utilisée par pratiquement toutes les grandes technologies, est un logiciel libre appelé scikit-learn qui a été développé par des instituts de recherche gouvernementaux. Les serveurs et les réseaux de Facebook reposent sur du matriel open source conçu par l’Open Compute Project (OCP).

Faut-il toujours croire à la propagande ?

Les apôtres du Cloud “distant et public” (on va l’appeler comme cela pour les différencier du cloud “local et privé” prôné par Smets) vont nous expliquer que nous ne saurons jamais gérer aussi bien nos data-centers que les Amazon, Microsoft et Google. C’est le discours actuel de la propagande mais, avec le temps, nous avons appris à ne pas toujours croire ce que nous racontait le “hype technique”, n’est-ce pas ?

Incident OVH : un “avant” et un “après” dans l’évolution vers le cloud ?

En conclusion, permettez-moi de revenir sur l’incendie du datacenter d’OVH à Strasbourg…

Inutile d’expliquer ce qui s’est passé dans la nuit du 10 mars : un (presque deux) bâtiment du datacenter d’OVH Cloud est parti en fumée (c’est le cas de le dire !)… Depuis, le débat fait rage sur la question des sauvegardes : certains disent que c’est de la responsabilité des clients alors que d’autres affirment (comme Louis Naugès) que c’est évidemment de la responsabilité de l’opérateur.

On ne va pas trancher ce débat ici et maintenant mais il est significatif de toutes les illusions qu’a engendrées la vague du cloud : tout d’un coup, l’informatique allait rimer avec “magique” alors qu’on était plutôt habitué à l’associer à “tragique”…

En revanche, ce que je crois c’est que cet incident ne va pas tout changer : l’évolution actuelle vers une informatique toute en ligne va se poursuivre. Mais tout comme les chaudières à vapeur (celles à “haute pression” du moins) explosaient de temps en temps à l’époque de la révolution industrielle, le chemin vers le cloud est également semé de quelques embûches et autres désillusions. C’est normal et même sain.

Si vous voulez que votre informatique en ligne soit tout le temps opérationnelle, quoi qu’il arrive, ne vous contentez pas de croire aux promesses de votre fournisseur mais prenez les choses en mains : mettez en place des redondances (oui, ça coûte cher), assurez-vous qu’il y ait des sauvegardes de faites (oui, c’est pénible) et que le personnel soit formé à concevoir et appliquer des plans de continuité d’exploitation (oui, c’est contraignant et complexe). L’exploitation, c’est comme la sécurité : c’est avant tout une histoire de personnel formé et motivé.